Stable diffusion web UI

跳到导航

跳到搜索

| |

| 基本资料 | |

| 软件名 | Stable diffusion web UI |

|---|---|

| 开发者 | AUTOMATIC1111及该项目的其他贡献者[1] |

| 操作系统 | Linux、Windows8及以上、macOS 10.9及以上 |

| 语言 | 英文(通过扩展支持多语言) |

| 软件类型 | AI绘画 |

| 许可协议 | AGPL-3.0 |

Stable diffusion web UI是基于Stable diffusion AI模型的AI绘画软件。

软件特点

Stable diffusion web UI是一个多功能的AI绘画软件,支持以下几个功能:

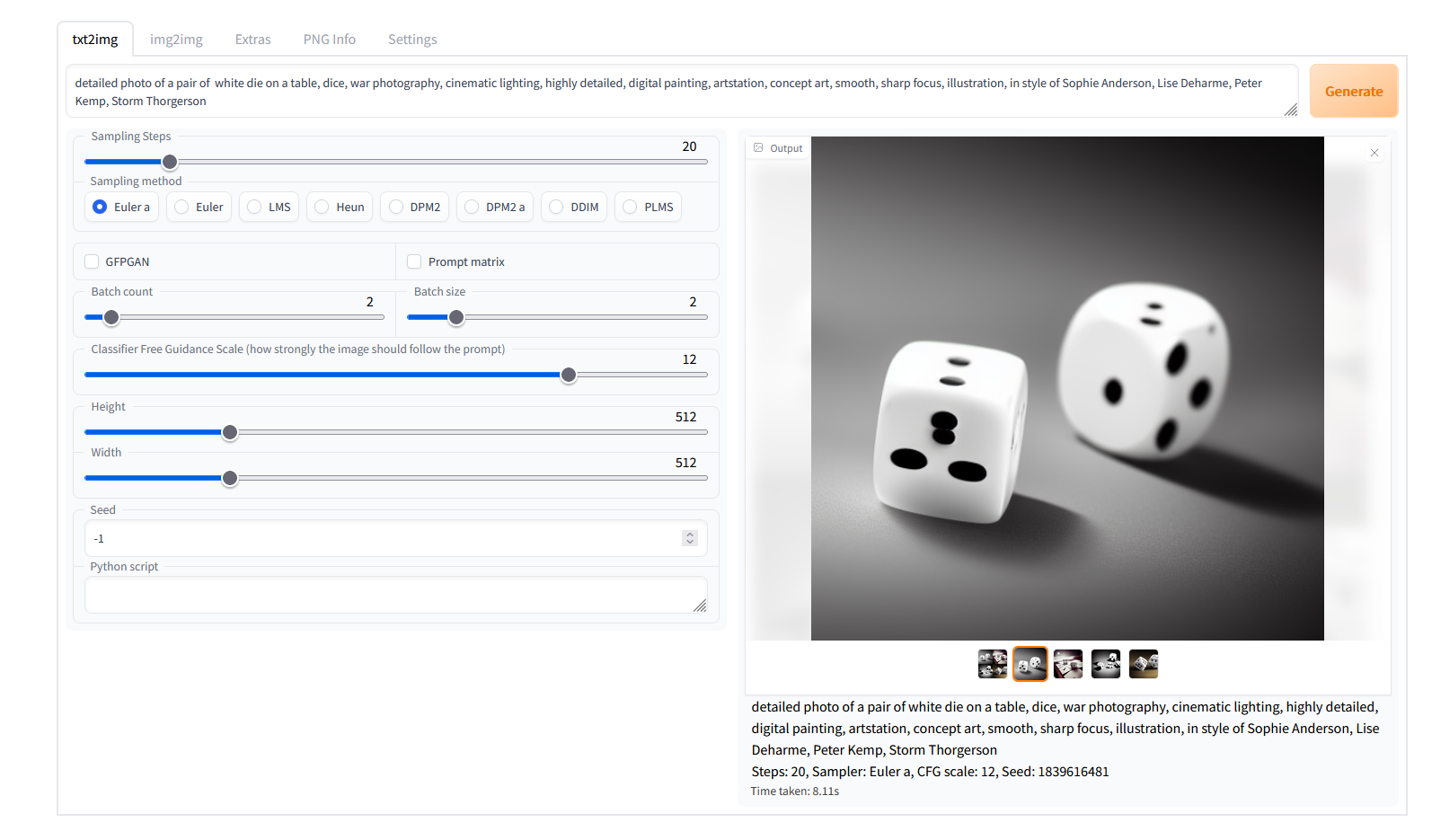

文生图

允许用户通过输入一堆关键词或者一句话来生成图片。除此之外,还支持设置生成图片的尺寸大小,使用的随机数种子(若为-1就是随机生成),采样的方式及采样步数(显著影响生成时间,适当多一些会改善图像质量,但是边际效应明显,次数过多收益不大)、生成批次(执行生成的次数)、每批数量(每次生成时生成几张图片,非常吃显存,不怎么常用)等参数。除此之外,若批量使用同一关键词来生成若干张图片,会自动将这些图片拼接起来。在生成按钮下方,有五个按钮,分别是应用上一次生成的提示词、清空提示词、快速更换各种模型(主生成模型、lora、超网络、嵌入式)、应用选中的模板、保存此时的生成设定为模板。除此之外,部分插件会增加一些额外功能。

在这里生成的图片,可以被移动到图生图或者附加功能(进行后处理)。

使用Stable diffusion web UI文生图功能生成的美人鱼动漫图片

图生图

使用用户输入的一堆关键词或者一句话以及一张图片来生成一张图片。和文生图一样,这里也支持调整一些参数。还有局部重绘功能,允许用户选定一个区域进行重绘,同时保留区域以外的图片内容。除此之外,用户还可以使用涂鸦画笔给已有图片做一些修改再拿去生成。

这里生成的图片可以重新作为图生图的输入进行生成或者进行局部重绘,除此之外,用户还可以将图片送往附加功能。这里也可以通过输入的图片自动生成关键词,可以使用CLIP与DeepBooru两种AI模型反推。CLIP较适用于写实风格图片,DeepBooru则适用于动漫图片。

附加功能

这部分类似于waifu2x,用户可以在这里调整图片的分辨率,可以设置等比例放大或者放大到指定分辨率(一般等比放大质量更好)。放大操作可以使用一些简单算法(如临近插值)或使用AI模型放大。AI模型放大拥有较高的质量,但需要较长的处理时间;而简单算法则质量较差,但是处理时间短。除此之外,还支持使用一些AI模型修复图片中人物的脸部。 输入所采用的图片可以来自于图生图、文生图,也可以来自于本地的文件夹。可以一次处理一张图片,也可以批量处理。

图像信息

这部分类似于一个普通的图片查看器,但是支持查看图片上携带的一些信息。比如说一张由本软件生成的图片将会在“parameters”参数中出现生成时所用的关键词句、生成步数、采样方法、提示词引导系数、随机数种子、图片尺寸、所用模型的哈希值等信息。在“postprocessing”参数中将会包含进行的图片后处理以及使用的参数(不包含分辨率缩放)。

模型合并

这里用户可以将两到三个个Stable diffusion系列的模型合并为一个,合并后的模型可能会生成一些不同于用于合并的模型的图片。除此之外,还支持替换模型的VAE(可变自动编码器,负责变换图像,影响图片画风)部分。除此之外还可以改变模型的格式,可以将ckpt格式的模型与safetensors格式的模型互相转换。(模型合并仅限高级用户,合并后的模型可能效果不好)

训练

这里用户可以使用自己的本地图片来训练嵌入式(Embedding)或者超网络(Hypernetwork) ,训练后的这些结构可以在生产图片时使用,能改变已有模型的画风、构图,产生一些新的图片一般用户不要想了,你显卡没那么多显存的,这里有着非常多的设置(除非你知道这些是做什么的,不然不建议瞎改)。如果想要了解更多内容,可以参考Textual Inversion(英文)。

扩展

在这里用户可以启用/禁用、更新自己已有的扩展插件,或者从网上获取扩展插件(可以从扩展插件名单中选择或者自己输入网址下载)。扩展程序有的是给Gui使用的翻译,有的则是给软件增加了新的功能。这里简单介绍一些常用的扩展插件。

简体中文语言包

这个扩展除了翻译了web ui本身的界面以外,还翻译了非常多的常用插件。这个插件已包含接下来介绍的所有插件的中文翻译。详细的安装与使用说明可以在插件的github页面看到。

Tag 自动补全

这个扩展可以在输入关键词时提供自动补全功能,尤其适用于输入booru风格(DeepBooru关键词反推就会生成这种关键词)的tag时。可以用这个扩展节省大量查找与输入关键词的时间。

ControlNet 插件(英文)

这个扩展提供了一些额外的控制图片生成的工具,允许使用手绘图、线框图、涂鸦或者使用预处理器处理图片生成法线贴图、人物姿态等额外信息控制图片的生成。这些额外信息可以单独或一起使用。在受到控制的情况下,生成的图片将会与输入的图片拥有相似的构图、人物姿态等特征。需要注意的是,这个扩展需要额外下载模型(在ControlNet modules safetensors处下载),并将模型放到软件根目录下的models\ControlNet文件夹里才可以使用。除此之外,这个插件目前只兼容1.x版本的Stable diffusion模型。

MultiDiffusion 放大器

这个扩展提供了一些算法以生成大尺寸图片。其中融合Vae算法几乎无成本的降低显存使用(可以只用4G显存就生成1080P图片),唯一的缺点是比直接生成时间要长一点小显存能跑起来就不错了。通过利用这个算法,还可以让图片的不同部位使用不同的提示词,进而更精细地控制图片的构图。除此之外,还提供了一种高质量的图片放大算法。

Lora

这个扩展是内置的。可以使用一些体积较小的模型(称为lora模型)影响生成的图片。具有可以改变画风、绘制特定人物的特点。有一些画师、ACGN作品开发商甚至提供部分自己作品内人物的Lora模型

使用说明

在开始使用前请确定你的电脑使用的GPU品牌和操作系统,并且必须安装Python 3.10以及Git(对于Linux,你还需要wget。对于Mac os,你还需要cmake、protobuf、rust与wget),同时保证这些软件在安装时都已经选择“Add to Path”(即正确设置了环境变量)。之后就可以从AUTOMATIC1111的Github仓库获取程序。如果你使用N卡,直接运行软件根目录的webui-user.bat(对于Windows用户)或webui-user.sh(对于Linux、Mac os用户)即可开始安装,之后会自动下载模型、各种依赖库体积非常大,注意你的硬盘空间,最后会给出一个网址,访问这个网址即可开始使用。如果你使用A卡,那么你必须使用Linux系统,运行webui-user.sh就可以自动配置(windows下目前也可以用,但是这不是受官方支持的并且安装比较麻烦,可参见Install and Run on AMD GPUs(英文))。如果你是苹果的Mac M系列的用户,那么你也只需要运行webui-user.sh就可以自动配置。目前对于intel的GPU和CPU的支持任然在开发中,如果你想要使用可以访问Installation on Intel Silicon(英文)以了解安装流程。如果你的操作系统和GPU组合不是以上的任何一种(如Mac os+A卡),那么你暂时不能使用此软件(随着软件的开发将会适配更多的平台)。

鉴于此软件配置安装非常的麻烦,且由于网络环境、系统硬件的问题经常安装失败,建议绝大多数用户使用别人制作的离线整合版,直接运行启动文件就可以了。

用文本编辑器打开启动文件(webui-user.bat(对于Windows用户)或webui-user.sh(对于Linux、Mac os用户))可以找到有一行包含“COMMANDLINE_ARGS=”。这是额外的启动参数,可以访问Command Line Arguments and Settings(英文)以了解详细设置。

关于模型

Stable diffusion web UI官方仅支持标准的Stable diffusion模型,其他基于Stable diffusion模型训练的模型没有官方支持,故这些模型能否运行比较看脸,不过实际上兼容性似乎还可以。

如果你需要使用其他生成模型(checkpoint),可以访问civitai(需要代理)或者huggingface。在下载时,可能会有不同格式的模型文件,出于安全的考量,建议下载safetensors格式的模型[2],除此之外,如果提供了额外的VAE文件,那么也需要下载。之后只需要将下载好的模型文件复制到软件根目录的models\Stable-diffusion文件夹里面。在生成图片时就可以在菜单里选择使用的模型了。

如果你需要更多的画风,需要使用嵌入式、超网络或者lora,也可以从civitai上找到这些模型。下载好之后放在软件根目录的models文件夹下的对应文件夹内即可使用。

除此之外,一个叫做Civitai Helper的扩展插件允许直接从civitai下载并安装各种模型。

| ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||